我如何将Apache Storm与我的实时分析系统集成?

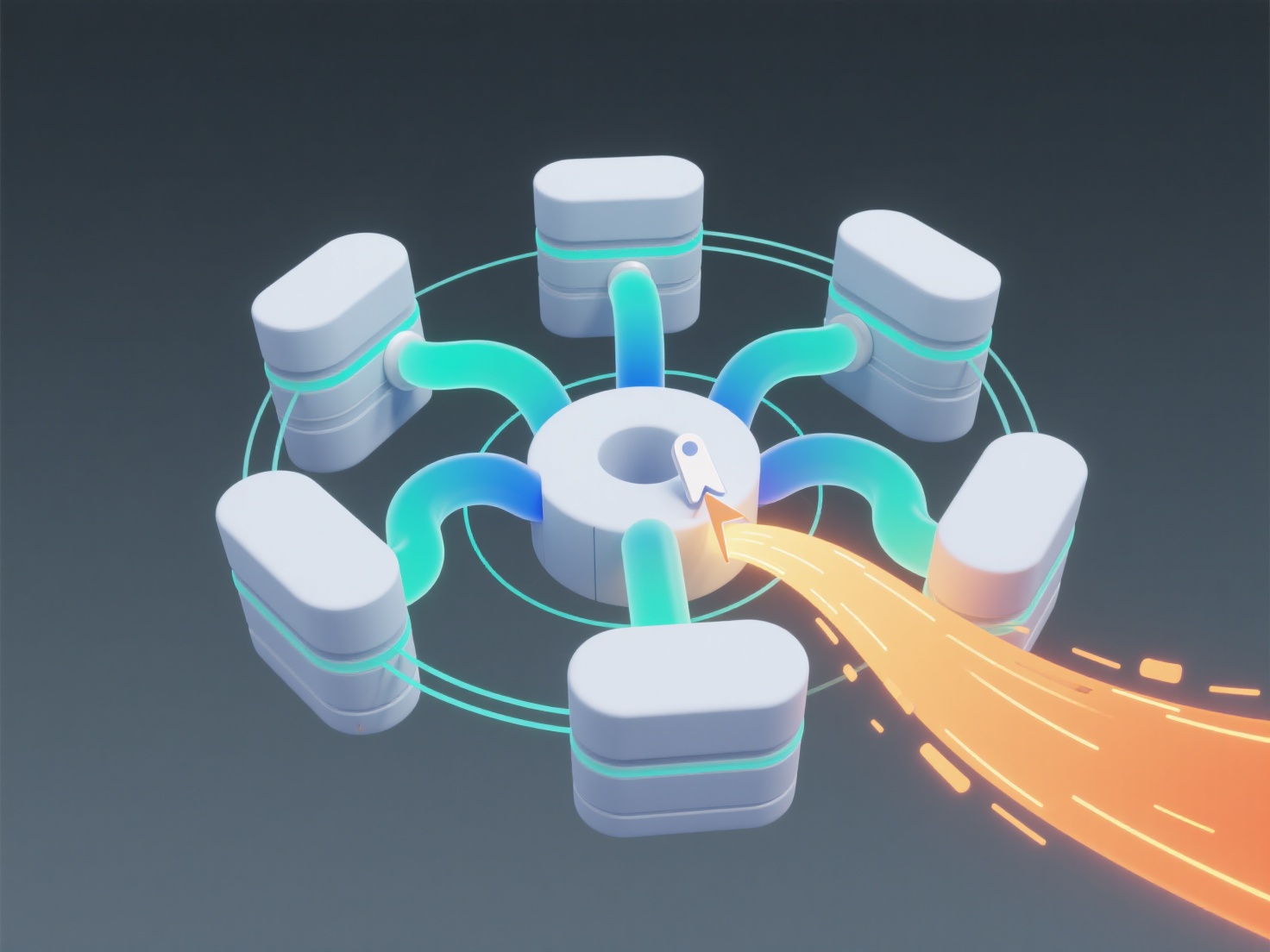

Apache Storm 处理高速数据流以进行实时计算。其低延迟能力可对持续到达的数据提供即时洞察和操作,这对于欺诈检测、物联网监控和动态个性化至关重要,在这些场景中处理延迟是不可接受的。

核心组件定义了 Storm 应用:**拓扑(Topology)** 表示计算图,由**喷头(Spouts)**(摄取流的数据源)和**螺栓(Bolts)**(执行过滤、聚合或机器学习等逻辑的处理单元)构建而成。**流分组(Stream Grouping)** 规定元组如何在螺栓之间路由(例如,随机分组、字段分组)。保证消息处理和可扩展性是关键原则,确保在工作节点上可靠、分布式地执行,有效处理海量数据。

集成涉及几个关键步骤。首先,将 Storm 依赖项添加到项目中。然后,设计拓扑:配置喷头以从数据源(如 Kafka、队列)消费数据,配置螺栓以实现特定的分析逻辑。在螺栓中嵌入代码,将结果写入数据库(如 HBase、Cassandra)、仪表板或其他系统。为喷头/螺栓配置并行度。将拓扑部署到 Storm 集群。此设置可提供近乎即时的分析,支持实时仪表板、警报系统和时间敏感的决策自动化,从而提高运营敏捷性。

继续阅读

实时数据分析将如何改变零售和面向消费者的行业?

实时数据分析涉及即时或近即时处理零售数据流,例如销售点交易、在线点击、传感器反馈和库存水平。它能即时洞察客户行为、库存变动和运营效率。关键应用包括动态定价调整、个性化促销和优化店内布局,从根本上增强对市场变化和消费者需求的响应能力。 核心组件包括可扩展的数据管道(如Apache Kafka)、流处...

Read Now →实时数据分析与批量数据分析有何不同?

实时数据分析在数据到达时持续处理数据,提供即时洞察,这对于欺诈检测或实时仪表板等时间敏感型决策至关重要。批处理数据分析按预定时间间隔处理大量存储数据,适用于生成全面的历史报告或进行数日、数周或数月的趋势分析。关键区别在于处理延迟和数据范围。 核心差异在于处理方法。实时分析采用流技术处理无界数据流,...

Read Now →我如何使用实时数据集成工具来简化数据处理?

实时数据集成工具在源系统中数据生成或变更时即时捕获和处理数据。关键概念包括变更数据捕获(CDC)、流数据摄取、内存处理和低延迟管道。这些工具对于要求数据即时可用的场景至关重要,例如运营分析、动态仪表板、欺诈检测和物联网应用,能够基于最新信息实现更快的决策制定。 这些工具通过以下方式运行:从数据库、...

Read Now →